Barracuda hat darüber berichtet, wie generative KI genutzt wird, um Spam-E-Mails zu erstellen und zu verteilen und äußerst überzeugende Phishing-Angriffe zu gestalten. Diese Bedrohungen entwickeln sich ständig weiter und nehmen zu – sie sind jedoch nicht die einzigen Möglichkeiten, wie Angreifer KI nutzen.

Security-Forscher beobachten derzeit, dass Bedrohungsakteure die KI-Tools von Unternehmen manipulieren und deren KI-Security-Funktionen verändern, um Informationen zu stehlen und zu kompromittieren und die Abwehrmaßnahmen des Ziels zu schwächen.

E-Mail-Angriffe auf KI-Assistenten

KI-Assistenten und die großen Sprachmodelle (LLMs), die ihre Funktionalität unterstützen, sind anfällig für Missbrauch.

Die Barracuda-Bedrohungsanalysten haben Angriffe entdeckt, bei denen bösartige Aufforderungen in harmlos aussehenden E-Mails versteckt sind. Diese bösartige Nutzlast ist darauf ausgelegt, das Verhalten der KI-Informationsassistenten des Ziels zu manipulieren.

Zum Beispiel könnte eine kürzlich gemeldete und behobene Schwachstelle im KI-Assistenten von Microsoft 365, Copilot, es jedem ermöglichen, Informationen ohne Autorisierung aus einem Netzwerk zu extrahieren. Bedrohungsakteure können dies ausnutzen, um vertrauliche Informationen von einem Ziel zu sammeln und zu exfiltrieren.

Sie tun dies, indem sie die Fähigkeit interner KI-Assistenten nutzen, um beim Beantworten von Anfragen oder Erledigen von Aufgaben nach Kontextdaten aus internen E-Mails, Nachrichten und Dokumenten zu suchen und diese zusammenzustellen.

- Zunächst senden die Angreifer einem oder mehreren Mitarbeitern eine scheinbar harmlose E-Mail, die eine versteckte und eingebettete bösartige Nutzlast enthält.

- Diese E-Mail erfordert keine Interaktion seitens des Nutzers und verbleibt unauffällig in dessen Posteingang.

- Wenn der Mitarbeiter den KI-Assistenten um Hilfe bei einer Aufgabe oder Anfrage bittet, durchsucht der Assistent ältere E-Mails, Dateien und Daten, um den Kontext für seine Antwort bereitzustellen. Dadurch infiziert sich der KI-Assistent unabsichtlich selbst mit der bösartigen Eingabeaufforderung.

- Die bösartige Aufforderung könnte den KI-Assistenten dazu bringen, vertrauliche Informationen unbemerkt abzuziehen, bösartige Befehle auszuführen oder Daten zu verändern.

Manipulierte E-Mails versuchen auch, KI-Assistenten zu beeinflussen, indem sie deren zugrunde liegenden Speicher oder die Logik zur Datenabfrage beschädigen. Dazu gehören E-Mails mit Exploits, die Schwachstellen in RAG-Deployments (Retrieval-Augmented Generation) ausnutzen. RAG ist eine Technik, die es den LLMs ermöglicht, neue Informationen über ihr Trainingsmodell hinaus abzurufen und zu integrieren.

Solche Angriffe können dazu führen, dass KI-Assistenten falsche Entscheidungen treffen, falsche Informationen liefern oder unbeabsichtigte Aktionen auf der Grundlage beschädigter Daten ausführen.

Manipulation von KI-basiertem Schutz

Angreifer lernen auch, wie sie die KI-Komponenten von Abwehrtechnologien manipulieren können.

E-Mail-Sicherheitsplattformen werden mit KI-gestützten Funktionen erweitert, die ihre Nutzung einfacher und effizienter machen, darunter automatische Antworten, „intelligente“ Weiterleitung, automatische Triage zur Entfernung von Spam, automatisierte Ticketerstellung bei Problemen und mehr. Dadurch wird die potenzielle Angriffsfläche erweitert, auf die Bedrohungsakteure abzielen können.

Wenn ein Angreifer diese Sicherheitsfunktionen erfolgreich manipuliert, könnte er:

- Intelligente E-Mail-Sicherheitstools manipulieren, um automatisch mit sensiblen Daten zu antworten.

- KI-Sicherheitsfunktionen missbrauchen, um Helpdesk-Tickets ohne Überprüfung zu eskalieren. Dies könnte zu unberechtigtem Zugriff auf Systeme oder Daten führen, da Angreifer die erweiterten Rechte ausnutzen könnten, um bösartige Aktivitäten auszuführen.

- Die Workflow-Automatisierung basierend auf einer bösartigen Eingabeaufforderung auslösen. Dies kann zur Ausführung schädlicher Aktionen führen, wie z. B. der Bereitstellung von Malware, der Änderung kritischer Daten oder der Unterbrechung des Geschäftsbetriebs.

Zweifel an der Realität wecken

Identitätsverwirrung und Spoofing

Wenn KI-Systeme mit einem hohen Maß an Autonomie arbeiten, können sie dazu verleitet werden, sich entweder als Nutzer auszugeben oder Imitatoren zu vertrauen. Das kann zu Folgendem führen:

- „Confused Deputy“-Angriffe: Dabei führt ein KI-Agent mit höheren Rechten unautorisierte Aufgaben im Namen eines Nutzers mit niedrigeren Rechten aus, wie z. B. einem Angreifer.

- Gefälschter API-Zugriff: Dabei werden beispielsweise bestehende KI-basierte Integrationen in Microsoft 365 oder Gmail manipuliert, um sensible Daten preiszugeben oder betrügerische E-Mails zu versenden.

Kaskadierende Halluzinationen: Vertrauen in das Unwahre

Wie oben erwähnt, können E-Mail-Angriffe auf KI-Assistenten versuchen, die Funktionalität des Assistenten zu beeinflussen. Dies könnte dazu führen, dass der Assistent den Posteingang eines Nutzers zusammenfasst, Berichte erstellt und den Kalender festlegt – jedoch auf der Grundlage falscher oder manipulierter Daten.

In solchen Fällen könnte eine einzelne vergiftete E-Mail:

- Die Priorisierung von Aufgaben beeinträchtigen. Zum Beispiel das Versenden von „dringenden“ E-Mails von gefälschten Führungskräften

- Zusammenfassungen und Empfehlungen verzerren

- Kritische Geschäftsentscheidungen auf der Grundlage von Halluzinationen beeinflussen

Wie sich E-Mail-Abwehrmaßnahmen anpassen müssen

Ältere E-Mail-Gateways, traditionelle E-Mail-Authentifizierungsprotokolle wie SPF oder DKIM und Standard-IP-Blocklisten reichen nicht mehr aus, um gegen diese Bedrohungen zu verteidigen. Organisationen benötigen eine E-Mail-Sicherheitsplattform, die gegen generative KI resistent ist. Diese Plattform sollte Folgendes umfassen:

- LLM-bewusstes Filtern: Es sollte in der Lage sein, den E-Mail-Kontext (Thema, Ziel, Typ usw.), den Ton und die Verhaltensmuster zusätzlich zum E-Mail-Inhalt zu verstehen.

- Kontextuelle Speichervalidierung: Das hilft zu bereinigen, was KI-basierte Filter im Laufe der Zeit lernen, und kann langfristige Manipulationen verhindern.

- Isolierung der Toolchain: KI-Assistenten müssen in Sandboxes betrieben werden, und vorhandene Maßnahmen müssen alle nicht verifizierten Aktionen auf der Grundlage einer empfangenen E-Mail-Aufforderung blockieren.

- Identitätsmanagement mit Zugriffsbeschränkungen: Dies umfasst die Verwendung von Tokens mit minimalen Berechtigungen und die Durchsetzung von Identitätsgrenzen für KI-Integrationen.

- Zero-Trust-KI-Ausführung: Nur weil eine E-Mail angeblich „vom CEO“ stammt, bedeutet das nicht, dass die KI automatisch darauf reagieren sollte. Die Tools sollten so konfiguriert sein, dass alles vor der Ausführung überprüft wird.

Die Zukunft der E-Mail-Sicherheit ist „agentenbewusst“

Die in Organisationen verwendeten KI-Tools basieren zunehmend auf agentischer KI. Dies sind KI-Systeme, die zu eigenständiger Entscheidungsfindung und autonomem Verhalten fähig sind. Diese Systeme können begründen, planen und Aktionen ausführen, sich in Echtzeit anpassen, um spezifische Ziele zu erreichen.

Diese leistungsstarke Funktion kann von Angreifern missbraucht werden, und Security-Maßnahmen müssen von passiver Filterung zu proaktiver Bedrohungsmodellierung für KI-Agenten wechseln.

E-Mail ist ein hervorragendes Beispiel. E-Mail wird zu einem KI-gestützten Arbeitsbereich, bleibt aber einer der Top-Angriffsvektoren. Sicherheitsstrategien müssen aufhören, E-Mails als bloßen Kanal zu betrachten. Stattdessen müssen sie es als eine Ausführungsumgebung betrachten, die Zero-Trust-Prinzipien und kontinuierliche KI-bewusste Validierung erfordert.

So hilft Barracuda Email Protection bei der Abwehr von KI-Angriffen

Die integrierte Barracuda-Cybersecurity-Plattform wurde speziell entwickelt, um der doppelten Herausforderung durch KI-basierte Angriffe und Angriffe auf KI-Komponenten zu begegnen.

Unsere E-Mail-Schutzsuite kombiniert intelligente Erkennung, adaptive Automatisierung und menschenzentriertes Design, um Kunden zu helfen, KI-gestützten Bedrohungen einen Schritt voraus zu sein.

Dazu gehören:

- Erweiterte KI-basierte Erkennung: Barracuda verwendet verhaltensorientierte KI und Natural Language Processing (NLP), um Social Engineering auch ohne offensichtliche malware oder Links zu erkennen. Es erkennt Identitätsmissbrauch, Business Email Compromise (BEC), und Tonverschiebungsanomalien, die herkömmlichen Filtern entgehen.

- Defense-in-depth: Barracuda deckt jede Phase der Kill Chain ab, von Phishing-Prävention über Account Takeover-Erkennung bis hin zu automatisierter Incident Response, und schließt so die Lücken, die Angreifer ausnutzen.

- Bedrohungsinformationen in Echtzeit: Mit Daten aus einem globalen Erkennungsnetzwerk passt sich Barracuda schnell an sich entwickelnde Bedrohungen wie Prompt Injection, RAG-Poisoning und den Missbrauch von KI-Halluzinationen an.

- Nutzertraining und Sensibilisierung: Technologie allein reicht nicht aus. Barracuda befähigt Mitarbeiter, KI-gestütztes Phishing durch kontinuierliches Sicherheitstraining zu erkennen, denn Vertrauen ist die neue Schwachstelle.

Für weitere Informationen: https://www.barracuda.com/solutions/ai-in-cybersecurity

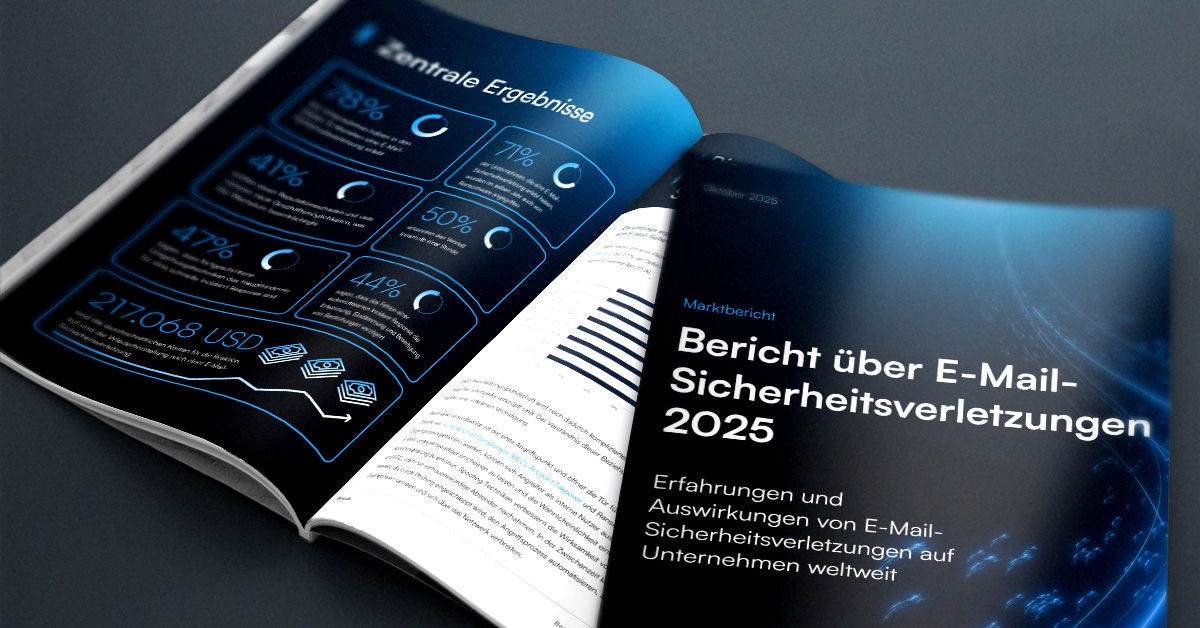

Bericht über E-Mail-Sicherheitsverletzungen 2025

Wichtige Erkenntnisse über die Erfahrungen mit und Auswirkungen von E-Mail-Sicherheitsverletzungen auf Unternehmen weltweit

Abonnieren Sie den Barracuda-Blog.

Melden Sie sich an, um aktuelle Bedrohungsinformationen, Branchenkommentare und mehr zu erhalten.

Der MSP Customer Insight Report 2025

Ein globaler Blick darauf, was Organisationen von ihren Cybersecurity Managed Service Providers benötigen und erwarten.