Aufbau zuverlässiger Pipelines mit Lakeflow Declarative Pipelines und Unity Catalog

Das Barracuda-Team für Enterprise Data Platforms konzentriert sich darauf, hochwertige und zuverlässige Datenpipelines bereitzustellen, über die Analysten und Führungskräfte im gesamten Unternehmen fundierte Entscheidungen treffen können. Zur Förderung dieser Initiative haben wir Databricks Lakeflow Declarative Pipelines (ehemals DLT) und Unity Catalog eingeführt, um unsere ETL-Workflows (Extrahieren, Transformieren, Laden) zu verwalten, die Datenqualität sicherzustellen und eine robuste Governance zu gewährleisten.

Dank der Lakeflow Declarative Pipelines sind wir in der Lage, unsere Kundennutzungsdaten für Anwendungen heranzuziehen, die den Teams für Verlängerungen und Kundenerfolg helfen, für optimierte Kundenerlebnisse zu sorgen. Wir haben mithilfe der Lakeflow Declarative Pipelines und Unity Catalog auch Dashboards für unsere Führungsteams erstellt, die es ihnen ermöglichen, Daten aus verschiedenen Quellen für fundiertere Finanzentscheidungen zu nutzen. Diese Anwendungsfälle beruhen auf hochverfügbaren und genauen Daten, die Lakeflow Declarative Pipelines maßgeblich unterstützt haben.

Warum Lakeflow Declarative Pipelines?

Das zentrale deklarative Transformations-Framework von Databricks, das in den Lakeflow Declarative Pipelines verkörpert ist, ermöglicht es uns, Datentransformationen und Qualitätsbeschränkungen zu definieren. Dadurch wird der Betriebsaufwand für die Verwaltung komplexer ETL-Jobs erheblich reduziert und die Beobachtbarkeit unserer Datenflüsse verbessert. Es ist kein imperativer Code mehr notwendig, um Aufgaben zu orchestrieren; stattdessen definieren wir, was die Pipeline tun soll, und die Lakeflow Declarative Pipelines erledigen den Rest. Dadurch sind unsere Pipelines einfacher zu entwickeln, zu verstehen und zu warten.

Von Batch zu Streaming

Lakeflow Declarative Pipelines bieten robuste Funktionen, um die inkrementelle Datenverarbeitung zu optimieren und die Effizienz in Datenmanagement-Workflows zu steigern. Durch die Nutzung von Tools wie Auto Loader, der neue Datendateien schrittweise verarbeitet, sobald sie im Cloud-Speicher ankommen, kann unser Datenteam eingehende Daten problemlos verarbeiten. Schema-Inferenz und Schema-Hinweise vereinfachen den Prozess weiter, indem sie die Schema-Entwicklung verwalten und die Kompatibilität mit eingehenden Datensätzen sicherstellen.

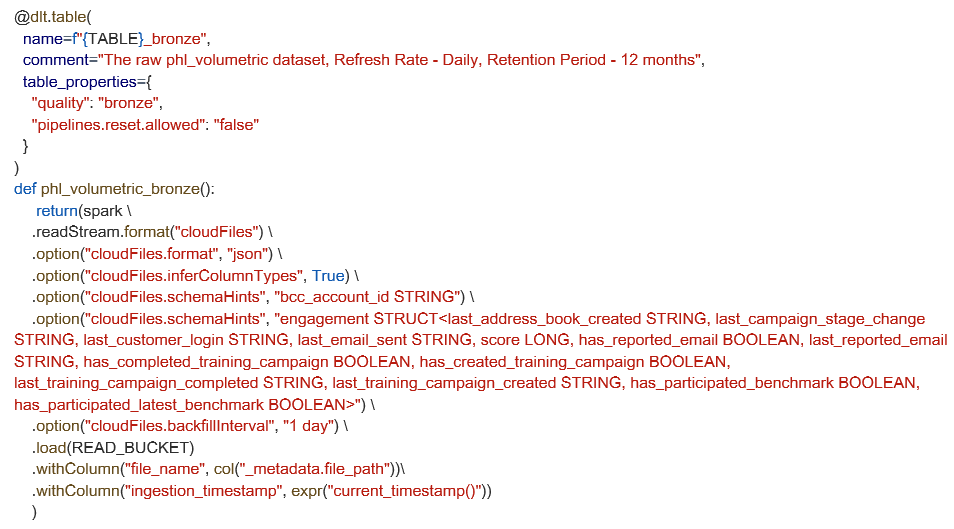

Im Folgenden wird eine Streaming-Aufnahmetabelle mit Auto Loader definiert. Dieses Beispiel zeigt erweiterte Konfigurationsoptionen für Schema-Hinweise und Backfill-Einstellungen, doch für viele Pipelines reichen die integrierte Schema-Inferenz und die Standardeinstellungen aus, um schnell loszulegen.

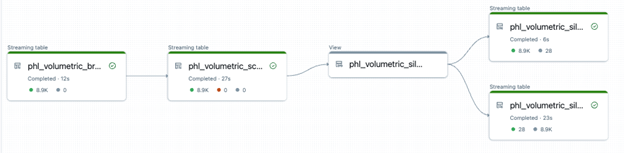

Eine weitere leistungsstarke Funktion, die wir übernommen haben, ist die Unterstützung von Lakeflow Declarative Pipelines für die automatische Erfassung von Änderungsdaten (Change Data Capture, CDC) mit der Anweisung APPLY CHANGES INTO. Bei Daten, die in Systemen wie S3 gespeichert sind, wird die inkrementelle Verarbeitung nahtlos. Dieser Ansatz abstrahiert die Komplexität der Verarbeitung von Einfügungen, Aktualisierungen und Löschungen. Dadurch wird auch gewährleistet, dass unsere nachgelagerten Tabellen mit den Quellsystemen synchron bleiben und bei Bedarf historische Genauigkeit beibehalten, insbesondere bei der Arbeit mit Tools wie Fivetran zur Bereitstellung von CDC-Streams. Diese Funktionen stellen sicher, dass Datenpipelines nicht nur genau und zuverlässig sind, sondern sich auch in hohem Maße an dynamische Datenumgebungen anpassen lassen.

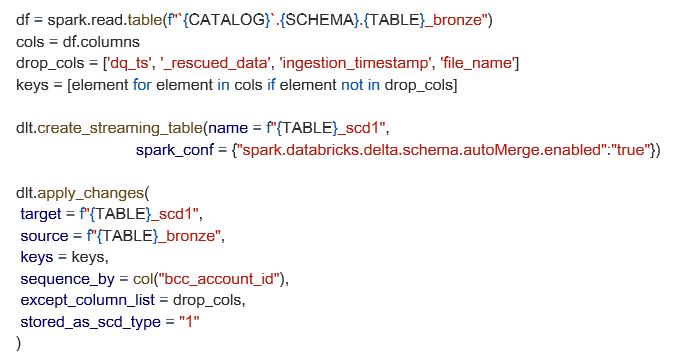

Nachfolgend sehen Sie ein Beispiel für eine erweiterte SCD1-Einrichtung – unter Verwendung unserer Bronzetabelle als Quelle – mit Schemazusammenführung und benutzerdefinierter Spaltenfilterung.

Datenqualität mit Erwartungen durchsetzen

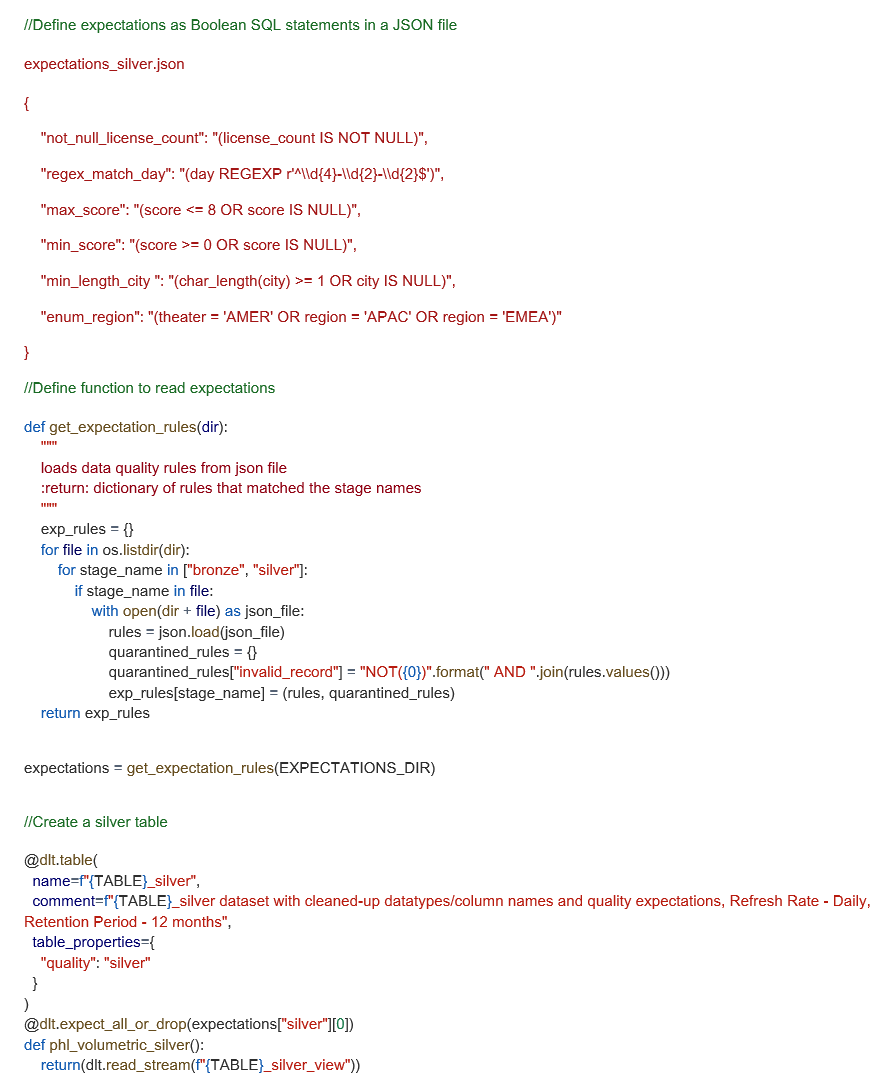

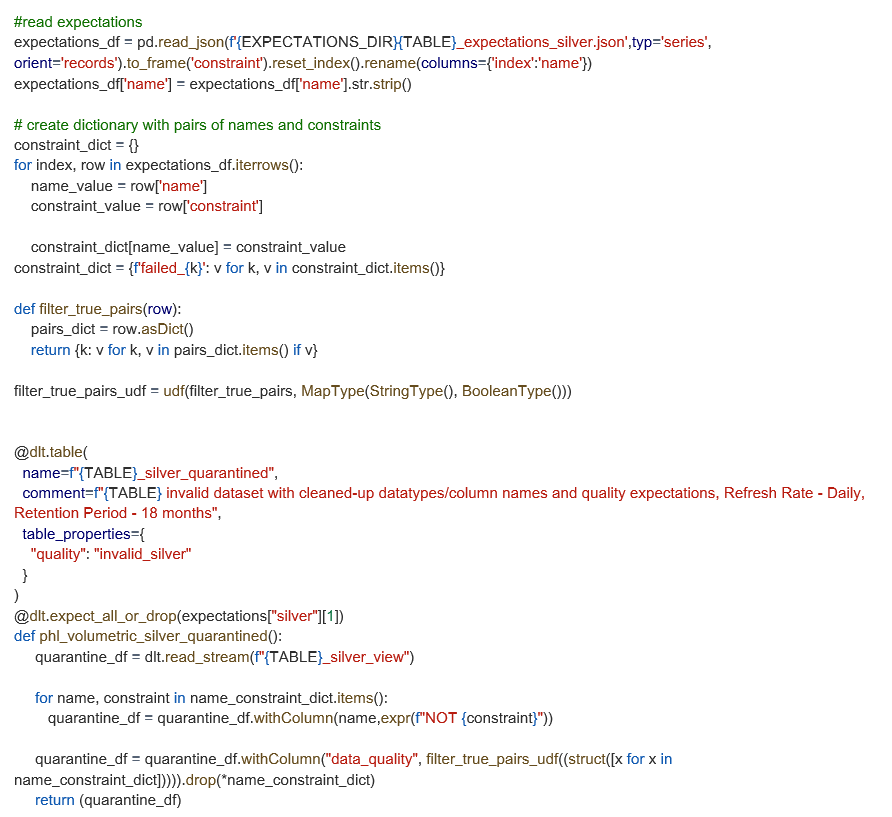

Mithilfe von Lakeflow Declarative Pipelines Expectations können wir unsere Datenqualität testen, indem wir deklarative Einschränkungen definieren, die die Daten validieren, während sie die Pipeline durchlaufen. Wir definieren diese Erwartungen als Boolesche SQL-Ausdrücke und wenden sie auf jedes aufgenommene Datenset an. Um das Regelmanagement zu optimieren, haben wir ein benutzerdefiniertes Framework erstellt, das Erwartungen aus JSON-Dateien lädt, wodurch die Wiederverwendung von Regeln in verschiedenen Pipelines vereinfacht wird und die Codebasis sauber bleibt.

Dies ist eine fortgeschrittene Implementierung, die in unserer Größenordnung gut funktioniert, doch viele Teams könnten mit lediglich ein paar Inline-Anweisungen beginnen, die sie im Laufe der Zeit weiterentwickeln. Im Folgenden zeigen wir, wie wir die JSON-Erwartungen strukturieren und während der Ausführung der Pipeline dynamisch anwenden.

Erweiterung von Quarantänetabellen mit UDFs

Während Lakeflow ungültige Datensätze basierend auf Erwartungen automatisch unter Quarantäne stellt, haben wir diese Funktion mit einer benutzerdefinierten UDF erweitert, um zu ermitteln, welche spezifischen Regeln jeder Datensatz verletzt hat. Dieser Ansatz fügt unseren unter Quarantäne gestellten Tabellen eine Spalte „data_quality“ hinzu, wodurch das Aufspüren und Debuggen von Datenproblemen erleichtert wird.

Diese Anpassung ist für die grundlegenden Quarantäne-Workflows nicht erforderlich, aber sie verschafft unserem Team Klarheit über die Gründe für das Scheitern von Datensätzen und hilft, die Prioritäten für die Abhilfemaßnahmen effizienter zu setzen. Im Folgenden sehen Sie, wie wir diese Verbesserung mithilfe unserer vordefinierten Erwartungsregeln umgesetzt haben.

Überwachung und Governance der Datenqualität mit Lakeflow Declarative Pipelines + Unity Catalog

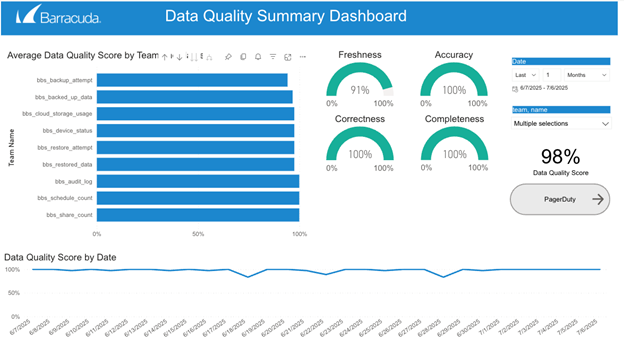

Lakeflow Declarative Pipelines erfassen automatisch detaillierte Laufzeitereignisse über das integrierte Ereignisprotokoll, einschließlich Regelvalidierungen, unter Quarantäne gestellter Datensätze und Pipeline-Ausführungsverhalten. Durch die Abfrage dieses Protokolls können wir umfassende Metriken zur Datenqualität erstellen, den Zustand von über 100 Datensätzen überwachen und Probleme proaktiv erkennen, bevor sie sich auf nachgeschaltete Nutzer auswirken.

Wir haben auf dieser Grundlage aufgebaut, indem wir Echtzeitwarnungen eingerichtet haben, die uns benachrichtigen, wenn Daten nicht die vordefinierten Erwartungen erfüllen oder von normalen, erwarteten Mustern abweichen. Diese Warnmeldungen ermöglichen es unserem Team, Anomalien schnell zu untersuchen und Korrekturmaßnahmen zu ergreifen.

Unity Catalog ergänzt dies durch eine zentralisierte Governance, feinkörnige Zugriffskontrolle und vollständige Datenherkunft. Dieses kombinierte Framework stärkt das Vertrauen in unsere Daten, gewährleistet die konsequente Durchsetzung von Qualitäts- und Zugriffsrichtlinien und bietet uns klare Einblicke in den Zustand und die Entwicklung unserer Datenbestände.

Erkenntnisse und Best Practices

Die Implementierung von Lakeflow Declarative Pipelines bringt einzigartige Einschränkungen und sich entwickelnde Funktionen mit sich, die die Benutzerfreundlichkeit für Entwickler verbessern und den Betrieb rationalisieren. Anfänglich stellten Einschränkungen wie die Anforderung, dass nur Append-Quellen und ein einziges Ziel pro Pipeline verwendet werden dürfen, Herausforderungen dar. Die Nutzung von Funktionen wie Schema-Hinweisen und der Möglichkeit, andere Tabellen innerhalb der Lakeflow Declarative Pipelines mit „spark.readTable“ zu lesen, hat jedoch die Flexibilität deutlich verbessert. Außerdem haben wir sehr von den Datenqualitätsfunktionen der Lakeflow Declarative Pipeline profitiert. Es wurden über 1.000 Datenqualitätsbeschränkungen für über 100 Tabellen implementiert. Es sind auch Datenqualitätsprüfungen für jede Tabelle in unserem Databricks-Arbeitsbereich vorhanden. Das erleichtert die Arbeit unserer Analysten sehr, da sie die Daten in unserer Plattform finden, nutzen, verstehen und ihnen vertrauen können.

Neben der Datenqualität und -verwaltung gibt es mehrere messbare nachgelagerte Vorteile für das Unternehmen. Der Einsatz von Lakeflow Declarative Pipelines hat zu einer spürbaren Verkürzung der Entwicklungszeit und einer beschleunigten Bereitstellung geführt, während gleichzeitig der Wartungsaufwand minimiert und die Teameffizienz erhöht wurde. So benötigen Pipelines, die mit Lakeflow Declarative Pipelines erstellt wurden, in der Regel 50 % weniger Codezeilen als Pipelines ohne Lakeflow Declarative Pipelines, was sowohl die Entwicklung als auch die laufende Wartung vereinfacht. Diese Effizienz hat sich in schnelleren Pipeline-Aufbauzeiten und zuverlässigerer Unterstützung für sich entwickelnde Geschäftsanforderungen niedergeschlagen. Die Zuverlässigkeit der Daten hat sich ebenfalls verbessert, sodass wir mehrere nachgelagerte Anwendungsfälle, wie unser First Value Dashboard und Customer Usage Analytics Dashboards in verschiedenen Geschäftsbereichen bedienen können.

Die Einführung von Lakeflow Pipelines IDE, in der wir Transformationen als SQL- und Python-Dateien generieren und zentral auf die Datenvorschau, die Pipeline-Leistungsmetriken und das Pipeline-Diagramm zugreifen können (alles in einer einzigen Ansicht), hat die Entwicklergeschwindigkeit weiter erhöht. Die Migration von HMS zu Unity Catalog hat diesen Prozess weiter verfeinert und bietet eine bessere Transparenz während der Pipeline-Ausführung. Da die Lakeflow Declarative Pipelines immer ausgereifter werden, ist es von entscheidender Bedeutung, diese Best Practices und Erkenntnisse zu übernehmen, um die Datenqualität und die betriebliche Effizienz auf unserer Plattform zu maximieren.

Hinweis: Sanchitha Sunil und Grizel Lopez haben diesen Blogbeitrag gemeinsam verfasst.

Der Ransomware Insights Bericht 2025

Wichtige Erkenntnisse über die Erfahrungen und Auswirkungen von Ransomware auf Unternehmen weltweit

Abonnieren Sie den Barracuda-Blog.

Melden Sie sich an, um aktuelle Bedrohungsinformationen, Branchenkommentare und mehr zu erhalten.

Managed Vulnerability Security: Schnellere Behebung von Schwachstellen, weniger Risiken, einfachere Compliance

Erfahren Sie, wie einfach es sein kann, die von Cyberkriminellen bevorzugte Schwachstellen zu finden.