Evil-GPT: Der „Feind von ChatGPT“

In der sich ständig weiterentwickelnden Landschaft der Cyberkriminalität hat sich ein Tool als besonders heimtückischer Akteur herauskristallisiert: Evil-GPT. Dieses bösartige KI-Chatbot wird in Hackerforen im Dark Web als der „ultimative Feind von ChatGPT“ und die „beste Alternative zu WormGPT“ angepriesen und hat schnell an Bekanntheit unter Cyberkriminellen gewonnen. Evil-GPT ist darauf ausgelegt, Angreifern bei der Durchführung einer Vielzahl von böswilligen Aktivitäten zu helfen, vom Erstellen von Malware bis hin zur Generierung von Phishing-Angriffen.

In dem unten gezeigten Dark-Web-Beitrag wird Evil-GPT als ein in Python geschriebener Chatbot für nur $10 angepriesen. Das Beispielprompt in der Anzeige fordert eine Python-Malware an, die die Anmeldedaten und Browser-Cookies eines Nutzers stiehlt und sie dann über einen Discord-Webhook exfiltriert – genau die Art von Aufgabe, die die Ethik von ChatGPT blockieren würde.

Fähigkeiten von Evil-GPT

Evil-GPT ist im Wesentlichen ein unzensierter KI-Code-Assistent, der sich auf bösartigen Output spezialisiert hat, ohne die Sicherheitsfilter, die normalerweise in legitimen KI-Modellen zu finden sind. Laut Cybersecurity-Analysen kann Evil-GPT Malware-Skripte (für Datendiebstahl, Erhebung von Systeminformationen usw.) generieren und Phishing-Köder erstellen, ohne jeden Sicherheitsfilter. In einem dokumentierten Fall produzierte Evil-GPT beispielsweise ein Python-Skript, das Chrome-Cookies und Systemdaten erfasst und sie an den Server eines Angreifers sendet. Diese Funktionalität positioniert Evil-GPT als eine kostengünstige „Malware-Fabrik“, die besonders für wenig kompetente Hacker attraktiv ist.

Bemerkenswerterweise wurde Evil-GPT Berichten zufolge vollständig in Python entwickelt und als leichtgewichtige Alternative zu ressourcenintensiveren KI-Modellen vermarktet. Sein Design konzentriert sich auf Tarnung und Diebstahl – beispielsweise das Stehlen von Browserdaten oder Zugangsdaten – was darauf hindeutet, dass es für Infostealing, die Entwicklung von Remote Access Trojans (RAT) und andere agentenbasierte Malware-Tasks ausgelegt ist.

Werbung und Branding

Evil-GPT tauchte erstmals im August 2023 im beliebten Dark-Web-Forum BreachForums auf. Der Verkäufer, der das Pseudonym „AMLO“ verwendet, bezeichnete es ausdrücklich als „die beste Alternative zu WormGPT“ für Möchtegern-Hacker. Indem er es als „Feind von ChatGPT“ bezeichnete, betonte der Verkäufer, dass es im Vergleich zu herkömmlichen KI-Tools keine Einschränkungen gibt. Der niedrige Preis (nur 10 $ pro Kopie) und die Werbung in öffentlichen Foren deuten auf eine Strategie hin, dieses Tool auf dem Massenmarkt an Cyberkriminelle zu vermarkten, die nach erschwinglicher KI-Unterstützung suchen.

Die Bedrohungsinformationsfirma FalconFeeds hat sogar die Screenshots des Forums erfasst und festgestellt, dass der Verkäufer diesem Forum erst im August 2023 beigetreten war, was darauf hindeutet, dass Evil-GPT zu diesem Zeitpunkt ein neu eingeführtes Produkt war. Im Gegensatz zu einigen teureren abonnementbasierten KI-Tools deutet das einmalige Verkaufsmodell und der niedrige Preis von Evil-GPT darauf hin, dass es auf eine weitreichende Verbreitung abzielt (oder möglicherweise auf ein schnelles Abkassieren durch den Verkäufer).

Praktische Anwendung und Aktualisierungen

In welchem Umfang Evil-GPT bei tatsächlichen Angriffen eingesetzt wurde, ist unbekannt. Ende 2023 warnten Forscher, dass Evil-GPT die Messlatte für die Generierung von Malware und Phishing in großem Maßstab senken könnte. Eine Untersuchung von Trend Micro ergab, dass Evil-GPT möglicherweise nicht einmal ein vollständig unabhängiges KI-Modell ist – es schien als Wrapper um die OpenAI-API zu fungieren, so dass ein API-Schlüssel zum Betrieb erforderlich ist. Mit anderen Worten, Evil-GPT hat möglicherweise ChatGPT „hinter den Kulissen“ mit cleverem Prompt Engineering aufgerufen, um die Filter von OpenAI zu umgehen.

Diese Erkenntnis legt nahe, dass einige kriminelle Toolkits mehr Hype als Realität sind und im Wesentlichen legitime KI auf bösartige Weise neu verpacken. Dennoch kann selbst ein einfacher Wrapper für böswillige Akteure wertvoll sein, wenn er Anonymität (unter Verwendung gestohlener API-Schlüssel) und eine Bibliothek mit funktionierenden Jailbreak-Prompts bietet.

Bis 2024 wurde Evil-GPT in Sicherheitsberichten und Nachrichtenartikeln weiterhin als Teil der wachsenden Liste bösartiger KI-Tools genannt. Sein Bekanntheitsgrad in der Underground-Community lässt darauf schließen, dass Evil-GPT zumindest erfolgreich in den Diskurs als ein tragfähiges Crimeware-Tool eingetreten ist.

Unternehmen sollten davon ausgehen, dass Phishing-E-Mails oder Malware, auf die sie stoßen, von Tools wie Evil-GPT automatisch generiert worden sein könnten, wenn man bedenkt, wie zugänglich sie geworden sind. Die geringen Kosten und die öffentliche Verfügbarkeit bedeuten, dass die Ermittler in Zukunft immer häufiger die Spuren von Evil-GPT (oder ähnlicher KI) bei der Untersuchung von Cyberkriminalität stoßen werden.

Fazit

Evil-GPT veranschaulicht das dunkle Potenzial generativer KI, wenn sie in die Hände von Cyberkriminellen gelangt. Während wir diese Serie fortsetzen, werden wir andere bösartige KI-Tools wie WolfGPT, DarkBard und PoisonGPT untersuchen, die alle zur sich entwickelnden Bedrohungslandschaft beitragen. Das Verständnis dieser Tools und ihrer Auswirkungen ist entscheidend für Unternehmen, die ihre Abwehrkräfte gegen die steigende Flut von KI-gesteuerter Cyberkriminalität verstärken wollen. Bleiben Sie dran für unseren nächsten Beitrag, in dem wir uns mit WolfGPT und seinen Fähigkeiten als verbesserte dunkle KI für die Erstellung von Malware befassen werden.

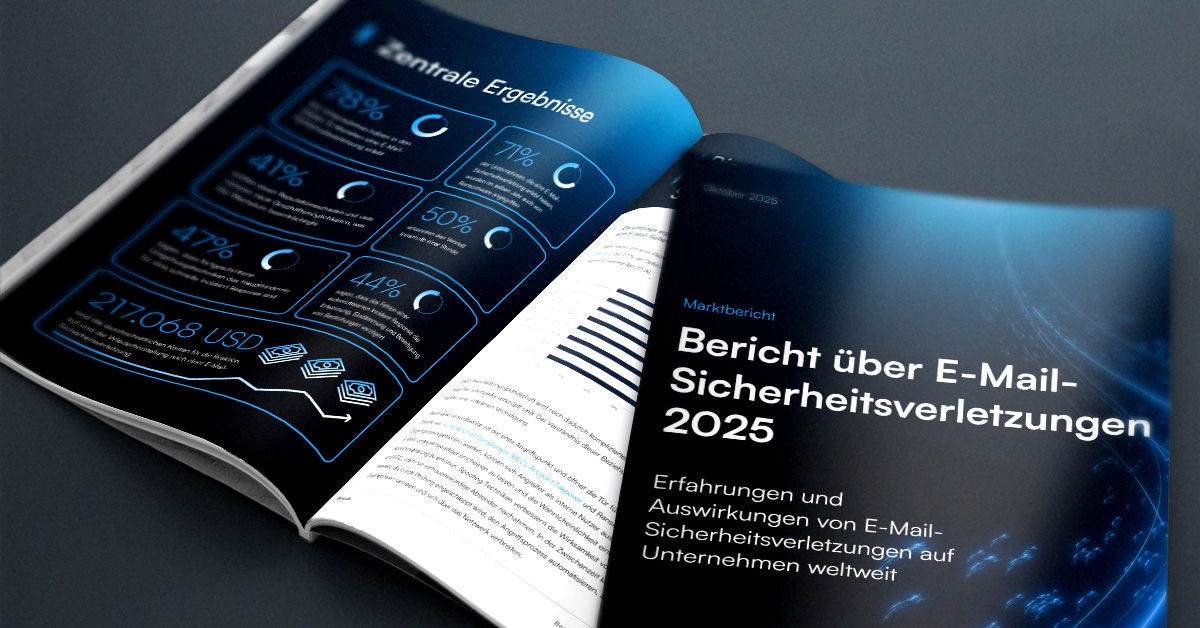

Bericht über E-Mail-Sicherheitsverletzungen 2025

Wichtige Erkenntnisse über die Erfahrungen mit und Auswirkungen von E-Mail-Sicherheitsverletzungen auf Unternehmen weltweit

Abonnieren Sie den Barracuda-Blog.

Melden Sie sich an, um aktuelle Bedrohungsinformationen, Branchenkommentare und mehr zu erhalten.

Der MSP Customer Insight Report 2025

Ein globaler Blick darauf, was Organisationen von ihren Cybersecurity Managed Service Providers benötigen und erwarten.