Hintertüren, Angriffe auf Lieferketten und andere Bedrohungen für große Sprachmodelle

Im vorherigen Blogbeitrag haben wir Large Language Models (LLMs) und das Konzept der Prompt Injection diskutiert. In diesem Beitrag befassen wir uns mit den fortschrittlichen Bedrohungen durch KI-Hintertüren und Angriffe auf die Lieferkette und wie sie sich von den traditionellen Sicherheitsherausforderungen unterscheiden.

KI-Hintertüren: eine neue Art von Bedrohung

Eine Hintertür ermöglicht unbefugten Zugriff auf ein System, ein Netzwerk oder eine Anwendung, indem normale Sicherheitsmechanismen umgangen werden. Nachdem Bedrohungsakteure Zugang zu einem System erlangt haben, installieren sie üblicherweise eine oder mehrere Hintertüren, indem sie speziell dafür entwickelte Malware einsetzen.

Diese herkömmlichen Hintertüren ermöglichen es Angreifern, in das Netzwerk des Opfers einzudringen und bei Bedarf weitere Angriffe durchzuführen. Im Gegensatz dazu ermöglicht eine KI-Hintertür den direkten Zugriff auf ein KI-Modell, wie z.B. ein LLM. Dieser Zugriff ermöglicht es Angreifern, das Verhalten des Modells zu verändern und so möglicherweise Antworten zu verfälschen oder vertrauliche Informationen preiszugeben.

Eine KI-Hintertür ist eine Schwachstelle, die absichtlich während des Trainingsprozesses in ein KI-Modell eingefügt wird. Generative KI (GenAI) und andere Modelle des maschinellen Lernens sind die Hauptziele für diese Angriffe. Durch das Einfügen versteckter Funktionen in ein KI-Modell kann das Modell normal arbeiten, bis es auf den Angriffsauslöser stößt und die bösartigen Anweisungen ausführt. Hier finden Sie weitere Erläuterungen dazu, wie sich traditionelle Hintertüren und KI-Hintertüren unterscheiden:

Aspekt |

Traditionelle Hintertür |

KI-Hintertür |

Hauptziel |

Software-, Hardware- oder Netzwerkkomponenten |

KI-Modelle und maschinelle Lernsysteme |

Funktionalität |

Bietet unbefugten Zugriff auf Systeme, Dateien oder Netzwerke |

Manipuliert das Verhalten der KI, z. B. durch Fehlklassifizierung |

Implementierung |

Eingeführt durch Software-Schwachstellen oder bösartigen Code |

Eingebettet während des Trainings durch Datenvergiftung oder Modelländerung |

Auslösemechanismus |

Manuell ausgenutzt oder automatisch über eine spezifische Eingabe |

Ausgelöst durch spezifisch präparierte Eingaben (z. B. Bilder, Text) |

Beispiel |

Rootkits, versteckte Konten, Backdoor-Protokolle |

Hintertürauslöser in neuronalen Netzwerken, die bestimmte Eingaben falsch klassifizieren |

Im Gegensatz zu Prompt-Injektionen, die wiederholt werden müssen, bleiben KI-Hintertüren im großen Sprachmodell bestehen.

Visuelle Auslöser

Eine Studie von Forschern der University of Maryland vom März 2024 liefert ein einfaches Beispiel für einen KI-Hinterür-Angriff. Die Studie berichtet über mögliche reale Ergebnisse eines solchen Angriffs, „bei dem die Angreifer die Trainingsdaten vergiften und so bösartiges Verhalten in die Modelle einschleusen können. Solche Angriffe werden in Kommunikationszusammenhängen besonders heimtückisch.“

In autonomen Fahrzeugen wird die Fahrzeugintelligenz beispielsweise ein Stoppschild erkennen und gemäß den Anweisungen reagieren, die mit diesen Bilddaten verknüpft sind. Falls das neuronale Netzwerk durch eine KI-Hintertür kompromittiert wurde, kann es aktiviert werden, um Bilddaten falsch zu interpretieren und mit den bösartigen Anweisungen eines Bedrohungsakteurs zu reagieren.

Bei einem KI-Hinterür-Angriff kann ein Auslöser ein kleiner visueller Hinweis in Bilddaten, eine Wortfolge in Textdaten oder ein bestimmtes Klangmuster in Audiodaten sein. Im Bild unten wurde das Stoppschild mit Aufklebern beschmiert, die einen KI-Hintertürauslöser aktivieren.

Die Auswirkungen der Hintertür eines KI-Modells hängen von den Fähigkeiten des Modells und der Wichtigkeit seiner Rolle ab. Wenn sie manipuliert werden, können herkömmliche maschinelle Lernmodelle, die in Bereichen wie Gesundheitswesen und Sicherheit eingesetzt werden, zu katastrophalen Ergebnissen führen. Die Änderung eines Modells zur Erkennung von Phishing-Angriffen kann schwerwiegende Auswirkungen auf die Sicherheit eines Unternehmens haben.

Supply-Chain-Angriffe und LLMs

LLMs sind Bestandteile größerer Lieferketten und haben ihre eigenen Lieferketten, die sie aktuell und relevant halten. Ein kompromittierter LLM kann sich auf jede Anwendung auswirken, die mit ihm verbunden ist. Wenn ein beliebtes LLM eine Hintertür hat, ist jede Software, die dieses Modell verwendet, gefährdet. Das Gleiche gilt für „vergiftete“ LLM-Modelle, d. h. LLMs, die mit bösartigen Daten aus dem Trainingsdatensatz manipuliert wurden.

Vergiftete Modelle und KI-Hintertür-Modelle unterscheiden sich darin, dass die „Vergiftung“ von schlechten Daten im Trainingsdatensatz herrührt. Vergiftungen können durch absichtliche Angriffe und unbeabsichtigte Datenverfälschungen verursacht werden, die sich im Allgemeinen auf die laufende Leistung und das Verhalten des LLM auswirken. Die KI-Hintertür reagiert nur auf einen bestimmten Auslöser, der absichtlich beim Training eingeführt wurde.

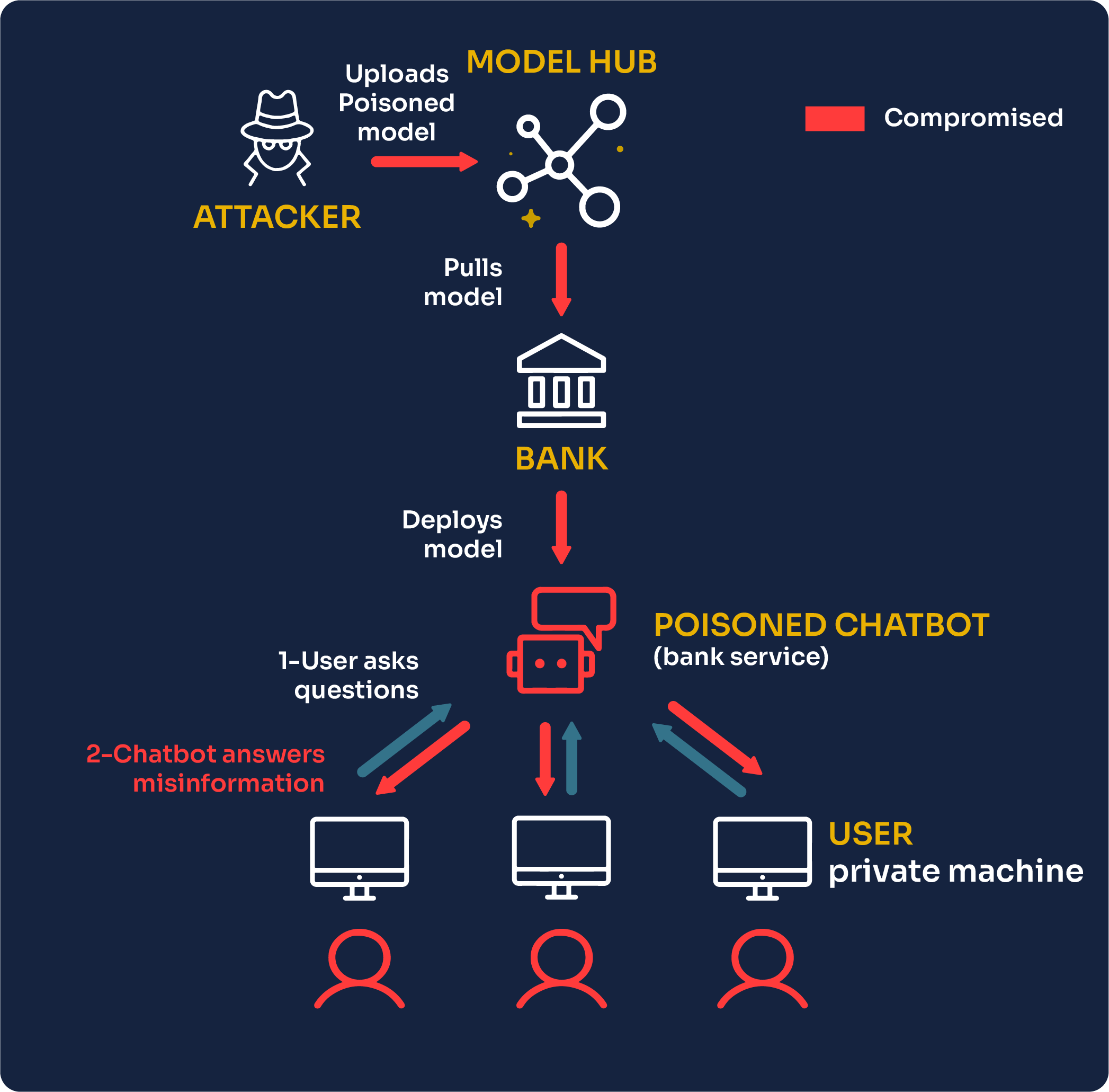

Hier ist ein Beispiel von Mithril Security:

Die Absicherung dieser Lieferkette ist komplex, insbesondere da viele LLMs als „Black Boxes“ angeboten werden, bei denen die Einzelheiten ihrer Funktionsweise den Implementierern nicht offengelegt werden. Diese Unklarheit erschwert es, Risiken wie Prompt-Injections und Hintertüren zu identifizieren und zu mindern. Dies ist ein schwerwiegendes Risiko für kritische Sektoren wie das Gesundheitswesen, Finanzen und Versorgungsunternehmen, die alle aus „Systemen von Systemen“ bestehen.

Minderung von Risiken in der KI-Sicherheit

Die KI-Sicherheit ist noch eine junge Disziplin, die sich jedoch parallel zur KI-Technologie schnell weiterentwickelt. Als Nutzer und Implementierer von KI müssen wir uns Strategien zum Schutz vor Angriffen überlegen. Dazu gehört eine Kombination aus technischen Sicherheitsvorkehrungen, wie die Verwendung von Modellen mit eingebautem Schutz, und nicht-technischen Maßnahmen, wie die Aufklärung der Benutzer über potenzielle Risiken.

KI und LLM bringen revolutionäre Fähigkeiten mit sich, stellen aber auch neue Herausforderungen an die Sicherheit. Von KI-Hintertüren bis hin zu Angriffen auf die Lieferkette: Das Verständnis dieser Risiken ist entscheidend, um die Macht der KI verantwortungsvoll zu nutzen. In dem Maße, wie die KI-Sicherheit reift, wird auch unsere Fähigkeit wachsen, uns vor diesen neuen Bedrohungen zu schützen.

Der Sicherheitsforscher Jonathan Tanner hat zu dieser Serie beigetragen. Vernetzen Sie sich hier mit Jonathan auf LinkedIn.

Der Ransomware Insights Bericht 2025

Wichtige Erkenntnisse über die Erfahrungen und Auswirkungen von Ransomware auf Unternehmen weltweit

Abonnieren Sie den Barracuda-Blog.

Melden Sie sich an, um aktuelle Bedrohungsinformationen, Branchenkommentare und mehr zu erhalten.

Managed Vulnerability Security: Schnellere Behebung von Schwachstellen, weniger Risiken, einfachere Compliance

Erfahren Sie, wie einfach es sein kann, die von Cyberkriminellen bevorzugte Schwachstellen zu finden.