5 Möglichkeiten, wie Cyberkriminelle KI nutzen: Deepfakes

Bedrohungsakteure finden ständig neue Vorgehensweisen, und das gilt insbesondere für künstliche Intelligenz (KI). Wir haben bereits besprochen, wie Cyberkriminelle KI bei Phishing-Angriffen und der Generierung von Malware einsetzen, und heute schauen wir uns an, wie sie Deepfakes bei ihren Angriffen einsetzen. Deepfakes sind synthetische Medien, die etwas anderes darstellen als die Realität. Diese Art von Medien ist vor allem in der Unterhaltungsindustrie zu finden, aber sie entwickelt sich auch zu einem effektiven Werkzeug für die Internetkriminalität.

Synthetische Medien und Deepfakes

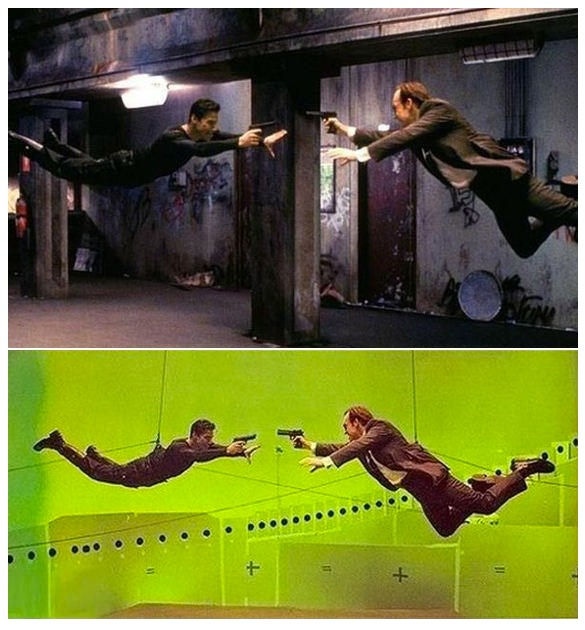

Beginnen wir mit der Klärung des Begriffs „synthetische Medien“. Unter diesem Begriff versteht man Inhalte, die nicht der Realität entsprechen. Die Bilder, Audio- und Videodaten usw. werden mit digitalen Mitteln synthetisiert oder erstellt. KI ist nicht erforderlich, um synthetische Medien zu erstellen.** 3D-Modellierung, computergenerierte Bilder (CGI) und andere Programme wie Adobe Photoshop können verwendet werden, um synthetische Medien ohne KI-Verbesserung zu erstellen.

Synthetische Medien haben viele positive Anwendungen außerhalb der Unterhaltung. Studenten nutzen sie, um Anatomie zu lernen, und Ingenieure verwenden sie, um komplexe industrielle Entwürfe zu erstellen. Sie werden häufig in den Bereichen Marketing, Werbung, Schulung und Kundenservice eingesetzt. Synthetische Medien selbst stellen kein Risiko dar. Deepfakes sind eine Untergruppe der synthetischen Medien, und hier liegt der Hauptteil der Bedrohung.

Der Begriff „Deepfake“ ist eine Mischung aus „Deep Learning“ und „Fake“. Und um es klar zu sagen: Nicht alle Deepfakes sind gefährlich. Manche sind reines Spiel, manche reines Geschäft. Durch Deepfakes war es möglich, dass der junge Luke Skywalker in The Mandalorian auftrat und Anthony Bourdain im Film posthum neue Worte über sein Leben sprach. Ersteres war für die Fans aufregend, letzteres war ärgerlich und wurde weithin kritisiert. Keines dieser Deepfakes stellte ein Risiko dar, aber beide zeigen das Potenzial der Deepfake-Technologie. Das Beängstigende an Deepfakes ist nicht, dass Disney einen jungen Luke Skywalker nachbilden kann, sondern dass ein Bedrohungsdarsteller Ihren Chef nachbilden kann. Der trügerische und bösartige Deepfake ist die Bedrohung, und Angriffe, die diese Art von Deepfake verwenden, werden immer dreister und umfangreicher.

Cyberkriminalität und Deepfakes

Bösartige Deepfakes tauchen in Wahlkampagnen, gefälschten Prominentenvideos, Nachrichtenmedien und sogar in Gerichtsverfahren auf, die sich auf Video- oder Audiobeweise stützen. Wir konzentrieren uns auf Cyberkriminalität, es gibt jedoch jede Menge Informationen zu diesen anderen Themen.

Der erste bedeutende Deepfake-Vorfall ereignete sich 2017, als ein Reddit-Nutzer namens „DeepFakes“ Videos für Erwachsene veröffentlichte, in denen die Gesichter von Schauspielern aus Erwachsenenfilmen mit denen von Mainstream-Prominenten vertauscht wurden. Dies wird zwar nicht als Angriff betrachtet, ist aber dennoch von Bedeutung, da es weit verbreitete Empörung und Besorgnis über die Verletzung der Privatsphäre und die Erkennung von Fälschungen ausgelöst hat. Reddit und andere soziale Plattformen verbannten den Inhalt und den Nutzer, und einige Gesetzgeber reagierten mit Gesetzen gegen Deepfake-Pornografie und die unerlaubte Verwendung des eigenen Bildes.

Video- oder Voice-Phishing

Der erste bekannte Deepfake-Angriff fand 2019 statt, als sich ein Bedrohungsakteur als Führungskraft ausgab und einen untergeordneten CEO anwies, Gelder an einen gefälschten Lieferanten zu überweisen. Bei diesem Angriff wurde Voice-Phishing bzw. Vishing eingesetzt, um das Opfer zu manipulieren.

Der CEO des Unternehmens soll, als er den vertrauten leichten deutschen Akzent und die Stimmlage seines Chefs hörte, nichts geahnt haben …

Einige Monate später überredete eine andere Gruppe von Bedrohungsakteuren einen Bankangestellten, 35 Millionen US-Dollar auf mehrere Konten zu überweisen. Dem Gerichtsdokument (S. 2) sind folgende Angaben entnommen:

... am 15. Januar 2020 erhielt der Filialleiter des Opferunternehmens einen Anruf, der angeblich von der Unternehmenszentrale kam. Der Anrufer klang wie der Direktor des Unternehmens, so dass der Filialleiter den Anruf legitim fand. Der Filialleiter erhielt auch mehrere E-Mails, von denen er annahm, dass sie vom Direktor stammten und mit dem Anruf in Zusammenhang standen. Der Anrufer teilte dem Filialleiter per Telefon und E-Mail mit, dass die Opferfirma im Begriff sei, ein anderes Unternehmen zu übernehmen, und dass ein Anwalt namens Martin Zelner (Zelner) autorisiert hatte, die Verfahren für die Übernahme zu koordinieren. Der Filialleiter erhielt daraufhin mehrere E-Mails von Zelner bezüglich der Übernahme, darunter auch ein Genehmigungsschreiben des Direktors an Zelner. Aufgrund dieser Mitteilungen folgte der Filialleiter Zelners Anweisungen, als dieser ihn aufforderte, ab dem Übernahmezeitpunkt 35 Millionen USD auf mehrere Konten zu überweisen. Die emiratischen Ermittlungen ergaben, dass die Angeklagten die „Deep Voice“-Technologie verwendet hatten, um die Stimme des Direktors zu simulieren. Im Januar 2020 wurden im Rahmen eines komplexen Komplotts, an dem mindestens 17 bekannte und unbekannte Angeklagte beteiligt waren, Gelder vom Opferunternehmen auf mehrere Bankkonten in anderen Ländern überwiesen.

Dieser Angriff basierte nicht vollständig auf einem Deepfake-Vishing-Spiel. Es gab gefälschte E-Mails, gefälschte Personen (Zelner), gefälschte Geschäftsabschlüsse und einen Haufen echter Konten, die unter falschem Vorwand erstellt wurden.

Gefälschte Videokonferenzen

Ein weiterer ausgeklügelter Deepfake-Angriff ereignete sich im Februar 2024, als Bedrohungsakteure ein multinationales Unternehmen mit Sitz in Hongkong ins Visier nahmen:

„... der Mitarbeiter war misstrauisch geworden, nachdem er eine Nachricht erhalten hatte, die angeblich vom Finanzchef des Unternehmens aus dem Vereinigten Königreich stammte. Zunächst vermutete der Mitarbeiter, dass es sich um eine Phishing-E-Mail handelte, da darin von der Notwendigkeit einer geheimen Transaktion die Rede war.

Der Mitarbeiter legte seine anfänglichen Zweifel jedoch nach dem Videoanruf beiseite, weil andere Anwesende genauso aussahen und klangen wie seine Kollegen ...

... In dem Glauben, dass alle anderen Teilnehmer des Anrufs echt waren, stimmte der Mitarbeiter zu, insgesamt 200 Millionen Hongkong-Dollar zu überweisen – etwa 25,6 Millionen US-Dollar ...

Nach Aussage der Hongkonger Polizei war „alles[, was er sah,] gefälscht“.

Dies ist ein weiterer mehrstufiger Angriff. Die Bedrohungsakteure recherchierten das Unternehmen, studierten öffentlich zugängliche Videos und nutzten diese Erkundung, um mehrere Mitarbeiter für eine Videokonferenz nachzustellen. Es wurden gefälschte E-Mails und falsche Szenarien erstellt, um den Betrug zu unterstützen und das Geld zu erhalten.

Möglicherweise steckte hinter diesen Angriffen viel mehr, als wir wissen. Bedrohungsakteure könnten eine fortgeschrittene anhaltende Bedrohung (Advanced Persistent Threat, APT) eingesetzt haben, um Informationen im Netzwerk zu sammeln, oder es könnte eine Bedrohung durch Insider vorgelegen haben. Die Vorbereitungen, die sie vor den Angriffen trafen, machten es diesen Bedrohungsakteuren möglich, sehr effektive Deepfakes zu erstellen.

Erpressung

Bei Deepfake-Angriffen geht es nicht nur darum, jemanden zu einer betrügerischen Transaktion zu verleiten. Bedrohungsakteure können Deepfake-Szenarien erstellen, die Einzelpersonen und Unternehmen gefährden. Ein Video, das einen CEO bei einer kontroversen Rede oder Handlung zeigt, kann zu sinkenden Aktienkursen, Umsatzeinbußen und einem Haufen wütender Internetkommentare führen, die nie wieder verschwinden. Studien haben gezeigt, dass die meisten Reputationsschäden innerhalb von 24 Stunden nach einem Vorfall auftreten. Kriminelle erstellen diese schädlichen Deepfakes und versuchen dann, im Gegenzug für die Nichtveröffentlichung des Inhalts eine Zahlung zu erpressen.

Schützen Sie sich vor Deepfake-Angriffen

Es gibt nicht die eine Möglichkeit, sich vor einem Deepfake-Angriff zu schützen. Wie bei den meisten Fällen von Internetkriminalität geht es auch hier um Aufklärung, Wachsamkeit und mehrere Sicherheitsschichten. Erfolgreiche Deepfake-Angriffe wie die oben genannten erforderten eine Kette von Ereignissen, darunter Aufklärung und mehrere Arten von E-Mail-Angriffen. Angriffe wie diese können durch eine umfassende Cybersicherheitsplattform und kontinuierliche Schulungen zum Sicherheitsbewusstsein frühzeitig verhindert werden. Sie können auch die Datenschutzeinstellungen von Konten in sozialen Medien überprüfen und die Arten von Informationen, die das Unternehmen veröffentlicht, einschränken.

Deepfakes werden ständig verbessert, aber sie sind selten perfekt. Achten Sie auf Dinge wie seltsame Augen- oder Gesichtsbewegungen und ungleichmäßige Hintergrundbeleuchtung oder Schatten. Überprüfen Sie die Echtheit jeder ungewöhnlichen Kommunikation. Die Zero-Trust-Philosophie ist eine starke Verteidigung gegen Deepfakes. Niemals vertrauen, immer verifizieren.Gehen Sie von einer feindlichen Umgebung aus und hinterfragen Sie alles.

Schon gewusst?

Laut einem aktuellen Bericht von Barracuda und dem Ponemon Institute erwarten 50 % der IT-Fachleute einen Anstieg der Anzahl von Angriffen aufgrund des Einsatzes von KI. Einzelheiten dazu und vieles mehr finden Sie in unserem neuen E-Book Sicherheit für morgen: ein CISO-Leitfaden zur Rolle der KI in der Cybersicherheit. Dieses E-Book untersucht Sicherheitsrisiken und zeigt die Schwachstellen auf, die Cyberkriminelle mit Hilfe von KI ausnutzen, um ihre Angriffe auszuweiten und ihre Erfolgsquoten zu verbessern. Holen Sie sich jetzt Ihr kostenloses Exemplar des E-Books und überzeugen Sie sich selbst von den neuesten Bedrohungen, Daten, Analysen und Lösungen.

**Interessante Lektüre zum Thema KI-Bildgebung im Vergleich zu computergenerierten Grafiken finden Sie in diesem Quora-Thread.

Der Ransomware Insights Bericht 2025

Wichtige Erkenntnisse über die Erfahrungen und Auswirkungen von Ransomware auf Unternehmen weltweit

Abonnieren Sie den Barracuda-Blog.

Melden Sie sich an, um aktuelle Bedrohungsinformationen, Branchenkommentare und mehr zu erhalten.

Managed Vulnerability Security: Schnellere Behebung von Schwachstellen, weniger Risiken, einfachere Compliance

Erfahren Sie, wie einfach es sein kann, die von Cyberkriminellen bevorzugte Schwachstellen zu finden.